En el debate sobre fiabilidad diagnóstica, solemos concentrarnos en los falsos positivos. Sin embargo, cuando el tiempo es determinante, como en pruebas rápidas de infección, cribados prenatales o biomarcadores agudos, el verdadero punto ciego aparece en el extremo contrario, el falso negativo. Un resultado que descarta erróneamente la presencia de enfermedad puede modificar por completo el curso clínico, favorecer errores terapéuticos y amplificar riesgos poblacionales.

Los estudios que revisamos (NEJM, CDC, análisis de inmunoensayos y la mayor revisión de NIPT (>750.000 casos) ofrecen un patrón consistente, los falsos negativos son menos visibles, pero mucho más determinantes.

TL;DR

Los falsos negativos son el mayor riesgo oculto en pruebas rápidas y cribados porque generan una falsa sensación de seguridad. A diferencia de los falsos positivos, que suelen detectarse y confirmarse, un falso negativo pasa inadvertido y puede retrasar tratamientos, favorecer contagios y distorsionar decisiones clínicas. La sensibilidad “real” de un test depende del contexto (probabilidad pretest, calidad de la muestra, fase de la enfermedad), por lo que un negativo nunca es un “no lo tiene”, sino una reducción de probabilidad. Para minimizar errores, es clave interpretar los resultados con enfoque de gestión del riesgo, considerar el valor predictivo, entender las limitaciones preanalíticas y repetir la prueba si la sospecha clínica sigue siendo alta. En diagnósticos rápidos, cerrar el caso demasiado pronto es más peligroso que confirmarlo dos veces.

El problema de fondo: Descartar es siempre más delicado que confirmar

En diagnóstico clínico, un falso positivo se suele detectar porque genera una reacción inmediata: obliga a repetir la prueba o realizar métodos confirmatorios. Es molesto, pero visible.

Un falso negativo es distinto: no genera ningún aviso. El resultado parece normal y el proceso clínico continúa sin que nadie tenga motivos para sospechar un error.

Esto lo explica de forma muy concreta el análisis publicado en The New England Journal of Medicine sobre COVID-19. Los autores señalan que un paciente infectado con un resultado negativo puede permanecer sin aislamiento, seguir interactuando con otros y transmitir la infección sin saberlo.

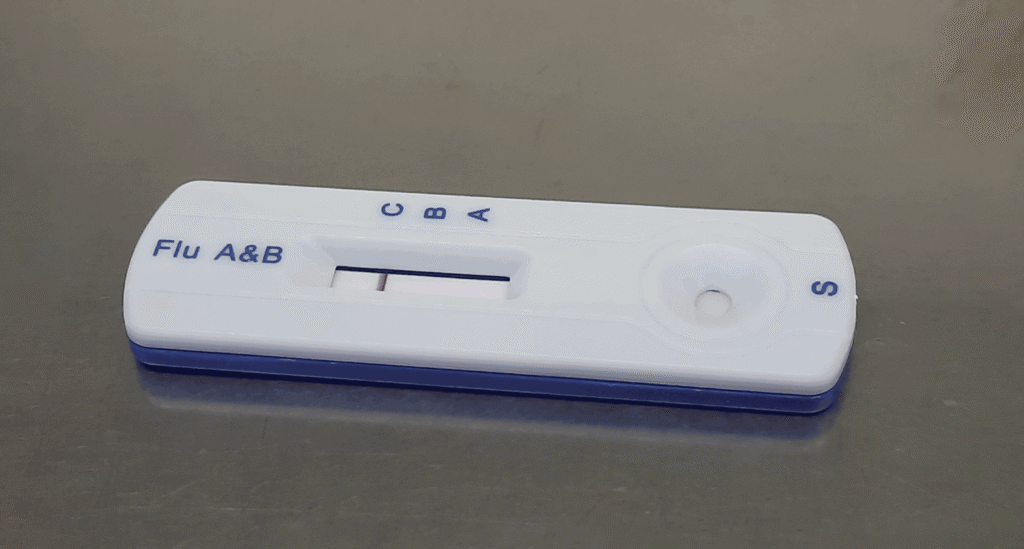

El CDC describe una situación similar en influenza. Los tests rápidos (RIDTs) muestran una sensibilidad del 50–70%, lo que significa que los falsos negativos son frecuentes, especialmente cuando el virus circula mucho en la comunidad.

Cuando la decisión clínica depende de descartar una enfermedad, por ejemplo, para dejar de aislar a un paciente, evitar pruebas adicionales o descartar un diagnóstico, un falso negativo tiene más impacto que un falso positivo, porque puede llevar a asumir que no existe un problema cuando en realidad sí lo hay.

Por qué se producen falsos negativos

Aunque los falsos negativos puedan parecer un simple fallo del test, la evidencia muestra que casi nunca hay una única causa. Lo relevante no es solo conocer estas causas, que están bien descritas en los estudios, sino entender cómo modifican la certeza diagnóstica y por qué son tan difíciles de detectar en la práctica clínica.

Podríamos destacar diversas causas que no actúan de forma aislada sino que se potencian entre sí, y eso explica por qué los falsos negativos aparecen justo en los momentos en los que la decisión clínica depende más de una interpretación fina.

Los tests están diseñados para convivir con el error

No existe un test perfecto. Siempre hay un equilibrio entre sensibilidad y especificidad. Cuando el sistema prioriza “no tratar de más” (evitar falsos positivos), inevitablemente sube el riesgo de falsos negativos. Esto es muy claro en inmunoensayos y cribados: se aceptan pequeños porcentajes de error porque el coste de confirmar luego un positivo es asumible.

La sensibilidad “real” no es un número fijo, es una franja

En infecciones respiratorias, por ejemplo, se han descrito falsos negativos que van de cifras muy bajas hasta el 30–40% según:

-

El tipo de muestra

-

El día de la enfermedad

-

La técnica de toma

Y con influenza pasa algo parecido, en condiciones ideales los tests rápidos parecen aceptables, pero en temporada alta la probabilidad de que un negativo sea erróneo crece de forma importante.

Eso significa que no podemos interpretar un negativo como si el test tuviera siempre su “mejor” sensibilidad. El rendimiento que importa es el de ese entorno concreto.

El sistema detecta mucho mejor los falsos positivos que los falsos negativos

Un falso positivo genera ruido: Dudas, nuevas pruebas, discusión. Termina llamando la atención y quedando registrado.

Un falso negativo, si el paciente no vuelve a tener problemas evidentes, no se descubre nunca.

En NIPT esto se ve clarísimo, los falsos positivos están bien cuantificados, pero los negativos casi no se siguen. Eso distorsiona la percepción y hace parecer que el problema es mínimo, cuando en realidad está poco medido.

La parte más frágil no es el test, es todo lo que pasa antes del test

Los datos de COVID, influenza y otros ejemplos apuntan a lo mismo. El tipo de muestra y la forma en que se toma importan muchísimo más de lo que puede parecer. Si la muestra no representa bien la biología del proceso (poca carga viral, zona equivocada, mala técnica), ningún test, por muy sofisticado que sea, puede “adivinar” lo que no está en la muestra.

Los falsos negativos no son un accidente extraño, son la consecuencia lógica de cómo están diseñados los tests, de cómo los usamos y de lo poco que vemos los errores que miran hacia el lado “tranquilizador”.

Qué cambia en la práctica clínica cuando entendemos esto

El siguiente paso no es seguir apilando cifras, sino preguntarse: qué haría distinto un clínico o un gestor si de verdad interioriza esto.

Un negativo no responde “sí/no”, responde “cuánto menos probable”

El modelo mental que suelen tener muchos profesionales es binario:

Positivo = lo tiene

Negativo = no lo tiene

Lo que están diciendo los datos es otra cosa. Un negativo sólo significa “ahora es menos probable que lo tenga”.

Cuánto menos probable depende de:

-

La probabilidad previa (sospecha clínica, contexto epidemiológico)

-

La sensibilidad real de ese test en ese entorno

-

La gravedad de equivocarse si en realidad sí lo tiene

Si tienes una enfermedad muy compatible clínicamente, en plena temporada, con un test cuya sensibilidad sabemos que cae en condiciones reales, un negativo reduce la probabilidad… pero no lo suficiente como para actuar como si fuera cero.

Eso es lo que hay detrás de recomendaciones del tipo “repita la prueba si la sospecha clínica sigue siendo alta”.

La decisión no es solo clínica, es también de gestión del riesgo

Los trabajos sobre gestión y farmacia clínica lo explican bien. Los falsos positivos y falsos negativos no cuestan lo mismo.

-

Un falso positivo suele implicar: Más pruebas, más costes, más ansiedad, algo de sobretratamiento.

-

Un falso negativo puede implicar: Ingresos evitables, complicaciones, contagios, litigios, pérdida de confianza.

Si lo pensamos como un problema de gestión de riesgo, la pregunta ya no es solo “¿Cuál es la sensibilidad?”, sino:

-

¿Qué prefiero asumir en este contexto concreto?

-

¿Qué error puedo permitirme más: Tratar de más o dejar sin tratar?

En urgencias con dolor torácico, por ejemplo, el sistema suele tolerar mejor un pequeño exceso de pruebas que el riesgo de mandar a casa un infarto. En cambio, en cribados masivos, se tiende a aceptar más falsos positivos porque hay una segunda línea confirmatoria.

La forma de comunicar los resultados es casi tan importante como el resultado

Todo este cuerpo de evidencia apunta a un punto incómodo: La manera en que informamos un “negativo” es a menudo engañosa.

En NIPT, por ejemplo, muchas pacientes perciben el negativo como “el bebé está bien”, cuando técnicamente significa “la probabilidad de ciertas anomalías concretas es baja, pero no cero, y no incluye otros muchos problemas posibles”. Si esa matización no se hace, el falso negativo rompe una expectativa de certeza que el test nunca prometió.

En infección aguda, algo similar. Decir simplemente “la prueba es negativa” sin añadir contexto (tipo de test, sensibilidad, momento de la toma, probabilidad previa) invita al clínico a sobreconfiar.

Con lo que no solo basta con mejorar los tests; hay que mejorar el lenguaje con el que se interpretan los negativos y siempre tener presente lo que tanto el positivo como el negativo significan.

Cómo debería cambiar la interpretación de un “negativo” a partir de todo esto

¿Cuál era la probabilidad antes del test?

No es lo mismo un negativo en:

-

Un paciente con pocos síntomas y baja prevalencia

-

Que en alguien con clínica muy sugerente en plena ola epidémica

En el segundo caso, la probabilidad previa es tan alta que un solo negativo con sensibilidad limitada no basta para cerrar el caso. Aquí es claro que cuanto más alta sea la sospecha clínica, menos peso tiene un negativo aislado.

¿Qué sé de la sensibilidad real de este test en este escenario?

No la del prospecto sino la observada en vida real.

-

¿Sé que la prueba rápida que uso tiene muchos falsos negativos en picos de circulación?

-

¿Sé que ese ensayo es menos sensible en ciertas muestras o fases de enfermedad?

-

¿Sé que, en este centro, hay problemas preanalíticos frecuentes?

Si la respuesta es sí a cualquiera de estas, automáticamente un negativo baja de categoría. Y ya no puede ser un argumento fuerte para descartar.

Al final, entender los falsos negativos no va de memorizar porcentajes ni de distinguir qué test tiene una sensibilidad más alta. Va de asumir que cualquier resultado negativo forma parte de un contexto clínico que se mueve, cambia y a veces engaña. Si algo demuestran todos estos datos, desde infecciones respiratorias hasta cribados prenatales, es que los tests no fallan solo porque sean imperfectos, sino porque los usamos en escenarios imperfectos: Pacientes que llegan tarde, muestras que no capturan lo que buscamos, validaciones que no reflejan la realidad y sistemas que observan mejor los errores que confirman un problema que los que lo descartan.

Por eso, más que obsesionarse con la cifra exacta de sensibilidad, lo que cambia la práctica es tratar cada negativo como una pieza más del rompecabezas, no como la última palabra. Cuando se interpreta así, muchos de los problemas asociados a los falsos negativos dejan de ser “fallos del test” y se convierten en mejores decisiones.

Cerrar la puerta demasiado pronto es siempre más peligroso que revisarla dos veces. Ese es, en esencia, el mensaje que une todos estos trabajos. Y es también la idea que debería guiar la lectura de cualquier negativo en diagnóstico rápido, no como un punto final, sino como una invitación a mirar un poco más de cerca.